ModelScope text2video Extensionとは?

「ModelScope text2video Extension」が登場しました。

これは動画作成機能を持つModelScopeをStableDiffusionWebUI上で実行できる拡張機能です。

作られる動画のクオリティはまだ荒いのですが、以下のような動画をテキストを元にして作ることができます。

現在はお試し版のためロゴが表示されるようです。

公式ページ

ModelScope text2video Extensionの導入方法

「拡張機能」⇒「URLからインストール」⇒「拡張機能のリポジトリのURL」の欄に公式ページのURL

https://github.com/deforum-art/sd-webui-modelscope-text2videoを入力してから「インストール」ボタンをクリックします。

次に以下のフォルダに移動します。

stable-diffusion-webui/modelsこのmodelsフォルダにModelScopeという名前の新規フォルダを作成します。さらにModelScopeの中にt2vという名前の新規フォルダを作成します。

以下のようにフォルダが作れれば大丈夫です。

stable-diffusion-webui/models/ModelScope/t2vt2vフォルダの中にHuggingFaceから4つのファイルをダウンロードして格納します。

- VQGAN_autoencoder.pth

- configuration.json

- open_clip_pytorch_model.bin

- text2video_pytorch_model.pth

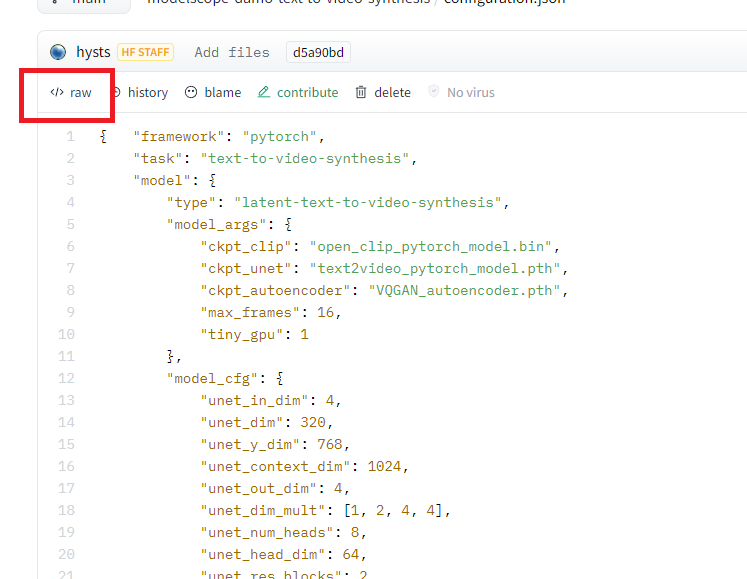

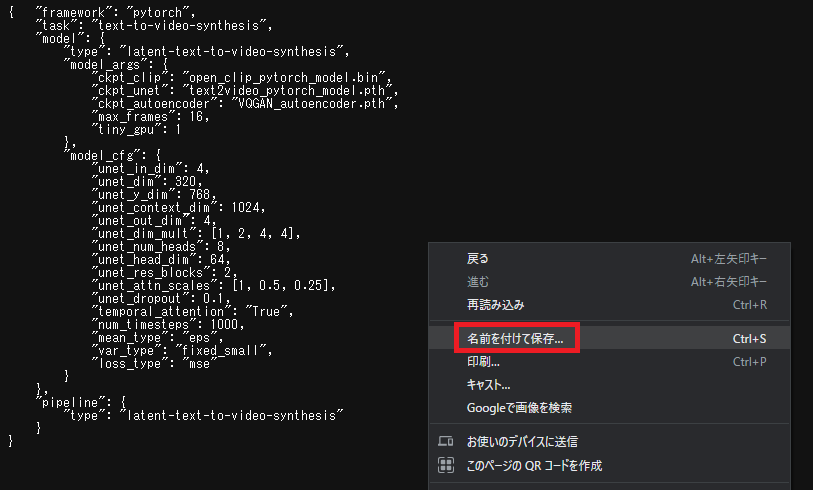

configuration.jsonだけは普通にダウンロードしても使えません。

</>rawというボタンをクリックします。

黒い画面が表示されるのでそこで右クリック。名前を付けて保存でt2vフォルダに格納してください。

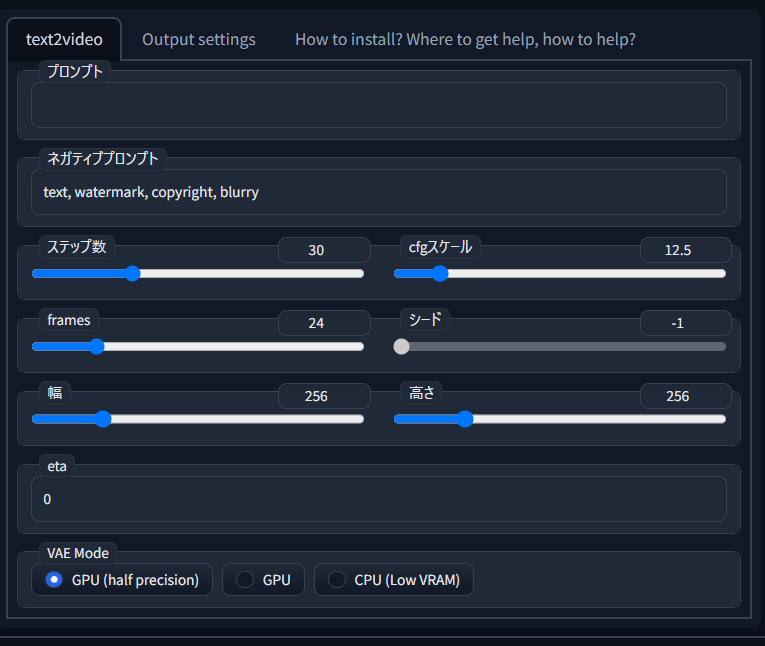

あとはWebUIを再起動してください。WebUIにModelscope Text2Videoというタブが追加され、以下の画面が表示できればインストール完了です。

ModelScope text2video Extensionの使い方

基本的な使い方はtxt2imgと同じです。

プロンプトに作りたいものをテキストで入力して、生成をクリックしましょう。

画像生成と違い、押してからかなり時間がかかりますが、辛抱強く待ってください。

生成が完了したらClick here after the generation to show the videoをクリックすると生成動画を見られます。

コメント